文章作者:Tyan

博客:noahsnail.com | CSDN | [简书](http://www.jianshu.com/users/7731e83f3a4e/latest_articles

0. 必备基础知识

卷积以及卷积的运算过程

微分相关知识,包括求偏导及链式法则

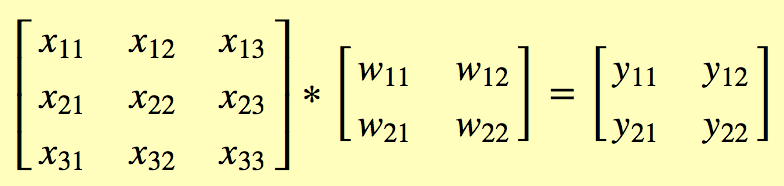

1. 卷积运算的前向传播

数学符号定义:

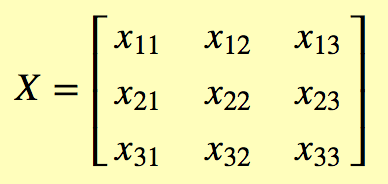

输入:

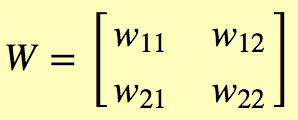

卷积核:

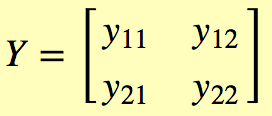

输出:

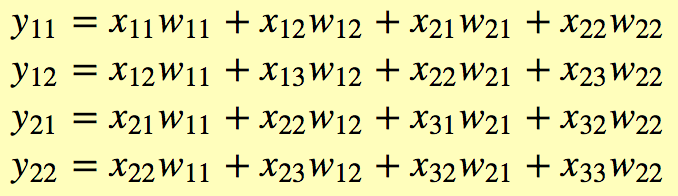

卷积运算:

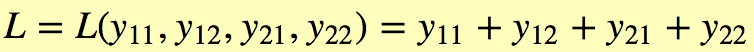

定义损失函数,将损失函数定义为输出的和,这样方便反向传播计算的演示:

从X -> Y -> L的过程是卷积运算的前向传播过程,为了简化这个过程,这里忽略了偏置项b以及卷积之后的激活函数。

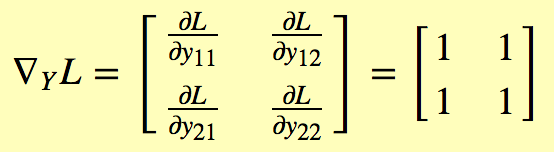

2. 卷积运算的反向传播

- 计算损失函数

L对输出Y的梯度

- 计算输入

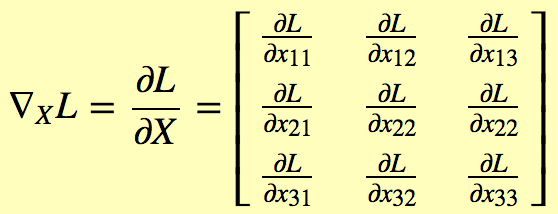

X的梯度

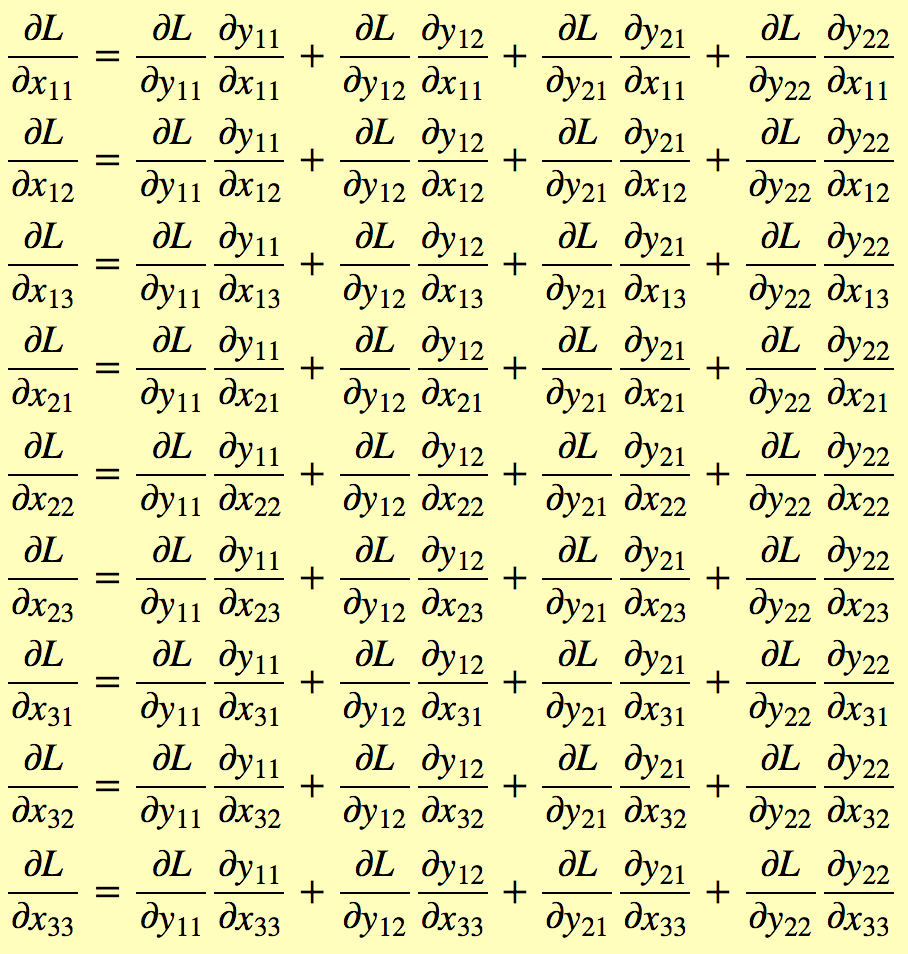

计算其中每一项的梯度:

- 计算卷积核

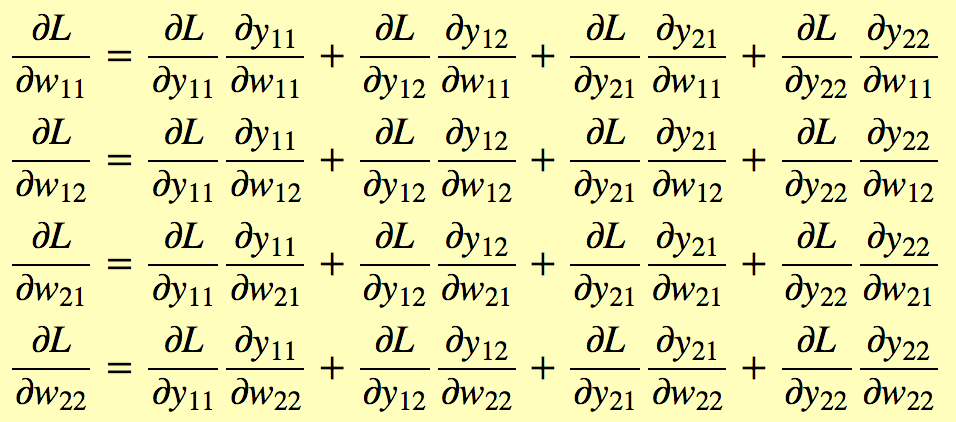

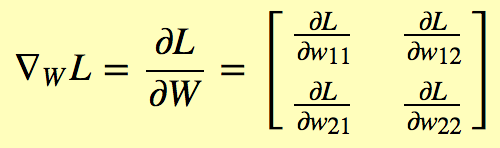

W的梯度

计算其中每一项的梯度: